深度学习

职场和发展

容器

极限编程

固态硬盘

YoloV5

swift

二分法

aws

微机原理

illustrator

界面设计

ECDSA

PIXIjs

startup packet

无线控制器

Java中的打印流

php桶装水配送系统

Sonar

halcon

模型压缩

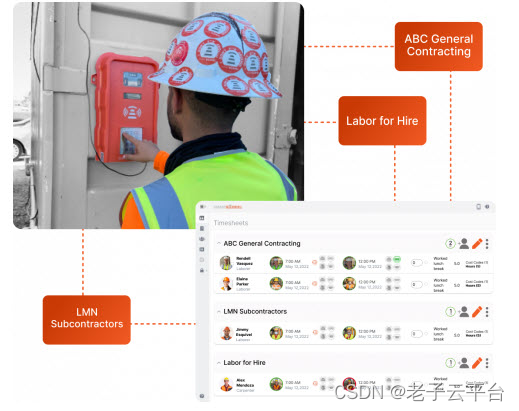

2024/4/12 6:13:167个影响AEC的AI工具

人工智能(AI)工具在各个行业中越来越受欢迎,ChatGDP的推出无疑让人们看到了人工智能所能提供的可能性。 然而,人工智能不仅仅是生成文本或图形——它可以用于各种设置。

建筑行业也不例外,我们才刚刚开始发现人工智能…

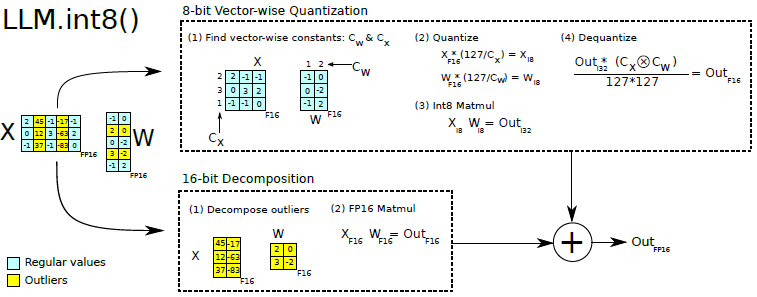

首篇大模型压缩论文综述

首篇大模型压缩综述来啦!!!

来自中国科学院和人民大学的研究者们深入探讨了基于LLM的模型压缩研究进展并发表了该领域的首篇综述《A Survey on Model Compression for Large Language Models》。

Abstract

大型语言模型(LLMs&a…

3D产品可视化SaaS

“我们正在走向衰退吗?”

“我们已经陷入衰退了吗?”

“我们正在步入衰退。”

过去几个月占据头条的问题和陈述引发了关于市场对每个行业影响的讨论和激烈辩论。 特别是对于科技行业来说,过去几周一直很动荡,围绕费用、增长和裁…

生成式语言大模型压缩技术思考——以ChatGPT为例

ChatGPT引领了生成式语言大模型的应用与技术热潮,首先简单回顾ChatGPT应用范式:将其应用于指定的下游任务时(如知识问答、翻译、编码),ChatGPT需要经历三个阶段的训练(增强人类语境的猜想)&…

NNI神经网络模型压缩教程

1. NNI简介

NNI是微软发布的一款自动机器学习(AutoML)开源项目,对机器学习生命周期的各个环节做了更加全面的支持,包括特征工程、神经网络架构搜索(NAS)、超参调优和模型压缩在内的步骤,你都能…

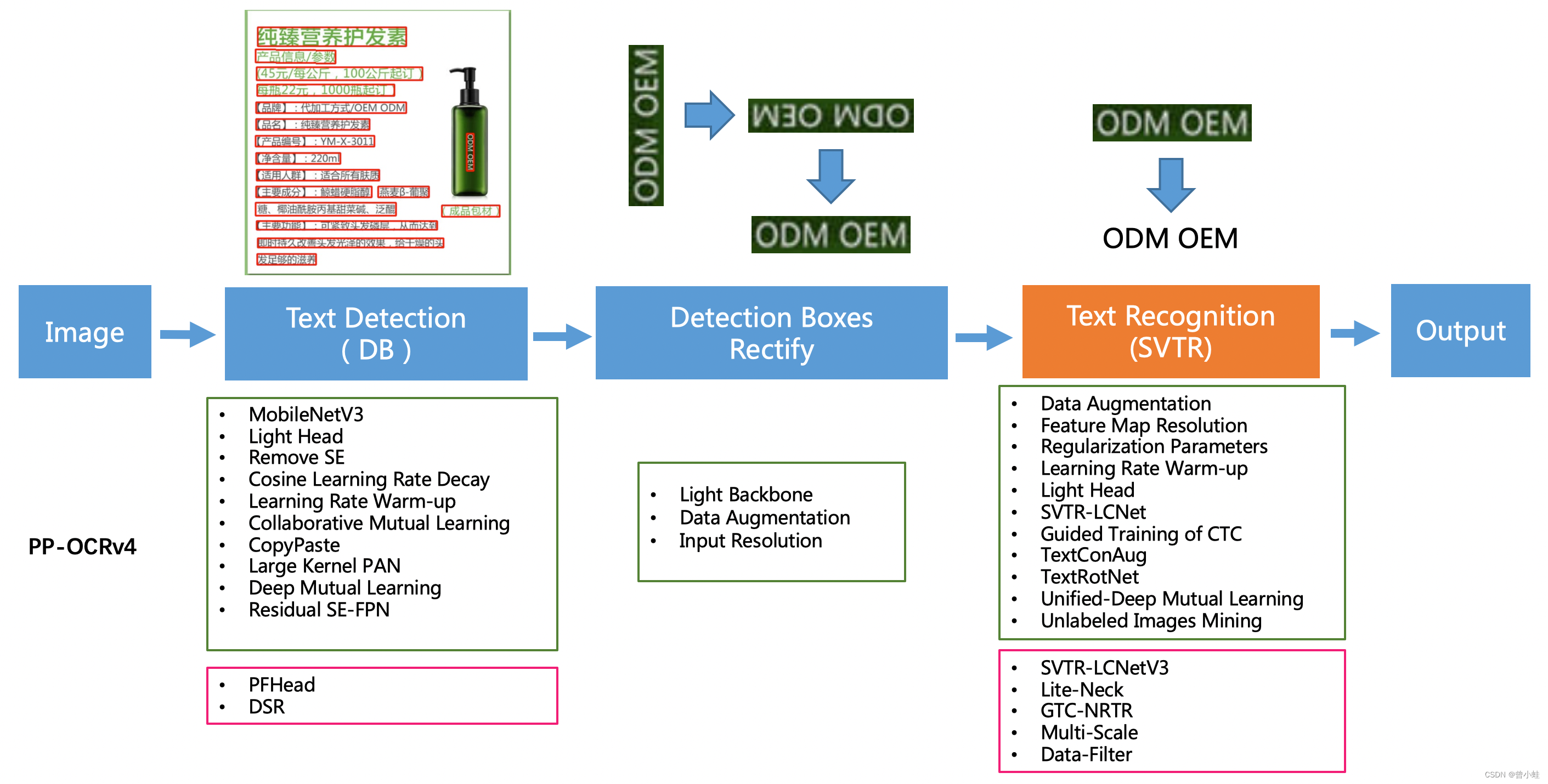

【论文简介】PP-OCRv1-v4中文字符识别论文概述

相关论文 2009.PP-OCR: A Practical Ultra Lightweight OCR System 2109.PP-OCRv2: Bag of Tricks for Ultra Lightweight OCR System 2206.PP-OCRv3: More Attempts for the Improvement of Ultra Lightweight OCR System 2308.PP-OCRv4:目前代码已发布(…

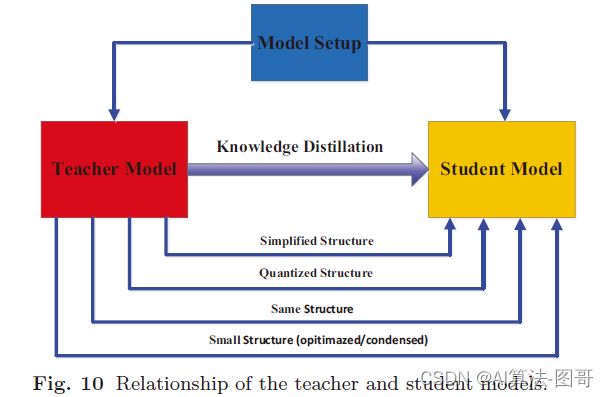

NeurIPS 2020 | MiniLM:通用预训练模型压缩方法

基本信息

机构: 微软研究院

作者: Wenhui Wang, Furu Wei, Li Dong, Hangbo Bao, Nan Yang, Ming Zhou

论文地址: https://arxiv.org/abs/2002.10957

论文代码: https://github.com/microsoft/unilm/tree/master/minilm

摘要…

推理引擎之模型压缩浅析

目录 前言1. 模型压缩架构和流程介绍2. 低比特量化原理2.1 量化基础介绍2.2 量化方法2.3 量化算法原理2.4 讨论 3. 感知量化训练QAT原理3.1 QAT原理3.2 量化算子插入3.3 QAT训练流程3.4 QAT衍生研究3.5 讨论 4. 训练后量化PTQ4.1 动态PTQ4.2 静态PTQ4.3 KL散度实现静态PTQ4.4 量…

模型轻量化、模型减面、模型压缩、模型优化合集

轻量化的概念:一个适用用于浏览器端渲染的模型数据,包括几何数据和行业数据,必然可以做的很小,如果和原建模软件的原始模型文件比较的话,如果做到1/4那是及格标准,做到1/10,乃至1/20之一是优秀。…

3d模型轻量化方法以及工具平台

3D模型轻量化是指减少3D模型的文件大小,以便在需要更快的数据传输或更快的渲染速度时使用。

一、以下是几种常见的3D模型轻量化方法:

1、移除不必要的细节:模型中可能存在一些细节,但这些细节对于渲染或使用模型并不重要。通过移…

【读点论文】A Survey of Quantization Methods for Efficient Neural Network Inference

A Survey of Quantization Methods for Efficient Neural Network Inference

Abstract

一旦抽象的数学计算适应了数字计算机的计算,在这些计算中如何有效地表示、处理和传递数值的问题就出现了。与数字表示问题密切相关的是量化问题:一组连续的实值数应该以何种方…

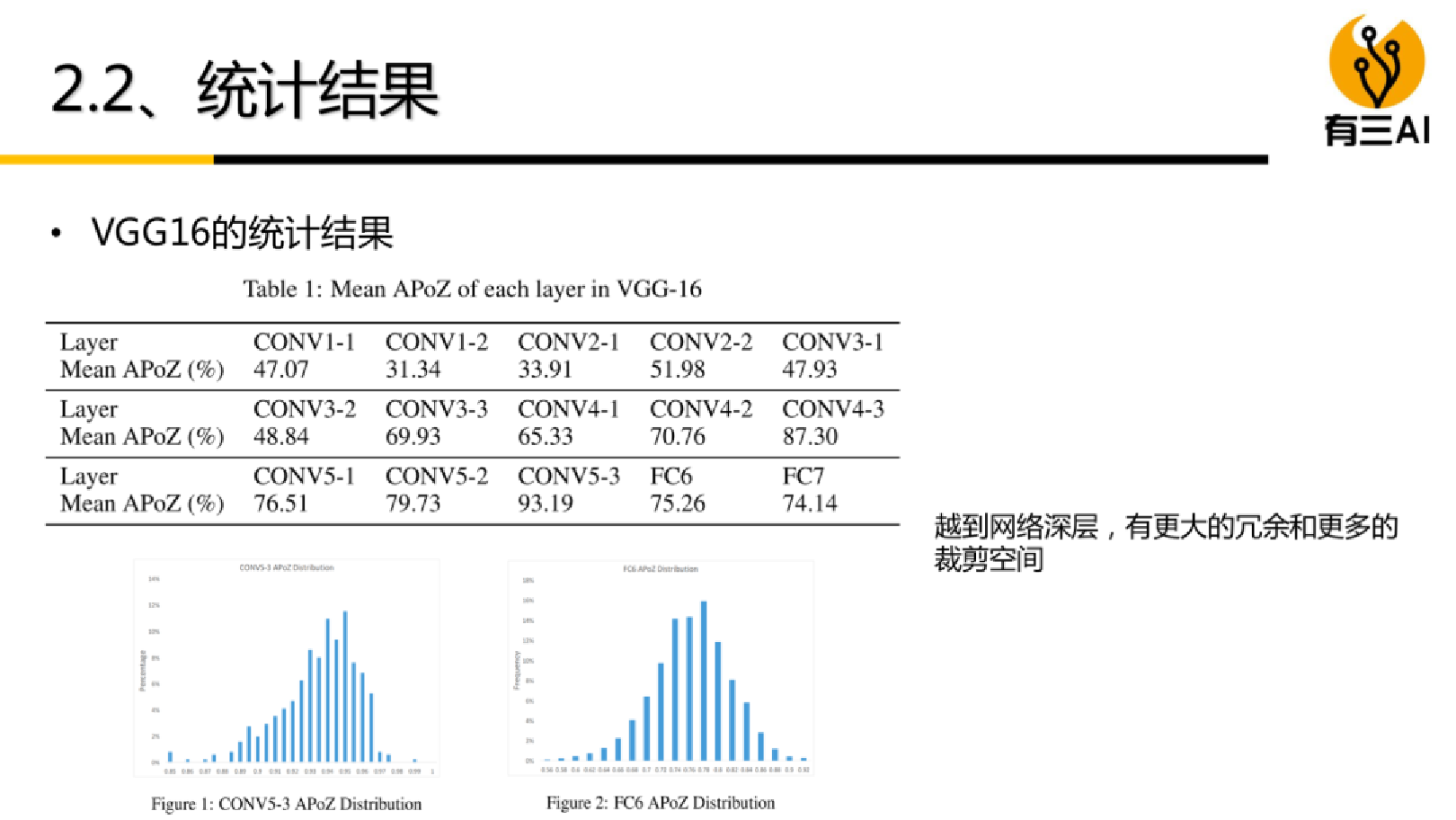

神经网络模型压缩技术—剪枝

目录

1.模型压缩定义

2.模型压缩必要性及可行性

3.模型压缩分类

3.1 主流分类

3.2 前端和后端

4.剪枝

4.1 剪枝定义

4.2 剪枝分类

4.2.1 基于粒度 4.2.2 基于是否结构化

4.2.3 基于目标

5. 结构化剪枝和非结构化剪枝

5.1 非结构化剪枝(移除单个权重或神…

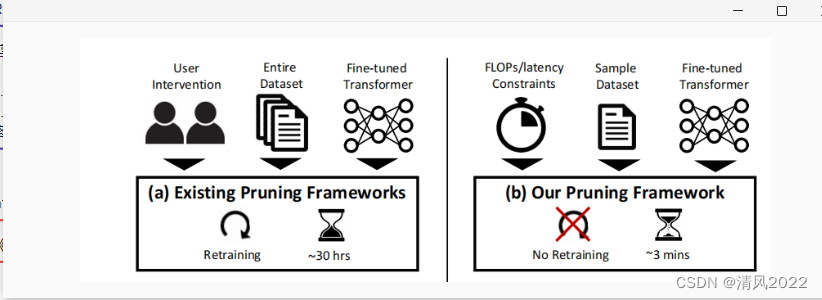

transformer剪枝论文汇总

文章目录 NN Pruning摘要实验 大模型剪枝LLM-PrunerSparseGPT LTPVTPWidth & Depth PruningPatch SlimmingDynamicViTSPViTDynamicBERTViT SlimmingFastFormersNViTUVCPost-training pruning NN Pruning

《Block Pruning For Faster Transformers》 《为更快的transformer…

三大3D引擎对比,直观感受AMRT3D渲染能力

作为当前热门的内容呈现形式,3D已经成为了广大开发者、设计师工作里不可或缺的一部分。

用户对于3D的热衷,源于其带来的【沉浸式体验】和【超仿真视觉效果】。借此我们从用户重点关注的四个3D视觉呈现内容:

材质- 呈现多元化内容水效果- 展…

模型优化【1】-低秩近似

模型优化-低秩近似 一、低秩近似 一、低秩近似

神经网络的基本运算卷积,实则就是 矩阵运算 ,低秩近似的技术是通过一系列 小规模矩阵将权重矩阵重构出来 ,以此降低 运算量和存储开销 。 目前有两种常用的方法实现低秩近似:

Toep…

模型压缩之Learning Efficient Convolutional Networks through Network Slimming

1. 摘要

在许多现实应用中,深度神经网络的部署由于其高额的计算成本变得很困难。在这篇论文中,我们提出了一种新颖的CNNs学习方案,它同时满足:

减小模型大小;减少运行时的内存占用;在不影响精度的同时&am…

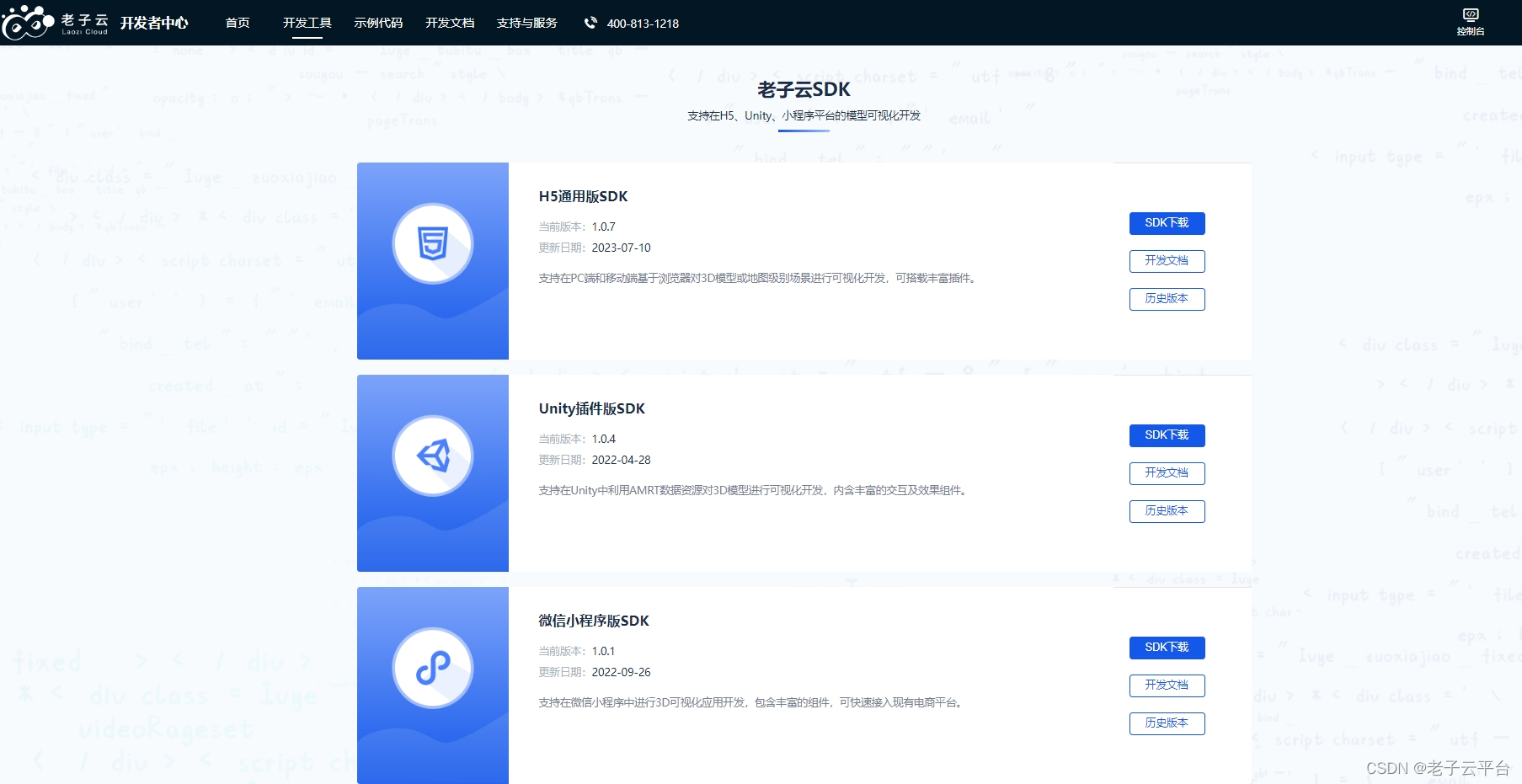

老子云、AMRT3D、眸瑞科技

老子云概述

老子云3D可视化快速开发平台,集云压缩、云烘焙、云存储云展示于一体,使3D模型资源自动输出至移动端PC端、Web端,能在多设备、全平台进行展示和交互,是全球领先、自主可控的自动化3D云引擎。 平台架构 平台特性

1、基…

EMNLP2020 | 模型压缩系列:BERT-of-Theseus(一种基于模块替换的模型压缩方法)

当古希腊神话遇到BERT,于是有了BERT-of-Theseus

背景

论文标题: BERT-of-Theseus: Compressing BERT by Progressive Module Replacing 论文作者: Canwen Xu, Wangchunshu Zhou, Tao Ge, Furu Wei, Ming Zhou 机构: 武汉大学、北…

一站式数据孪生工具平台

老子云3D可视化快速开发平台,集云压缩、云烘焙、云存储云展示于一体,使3D模型资源自动输出至移动端PC端、Web端,能在多设备、全平台进行展示和交互,是全球领先、自主可控的自动化3D云引擎。此技术已经在全球申请了专利定义为 AMRT…

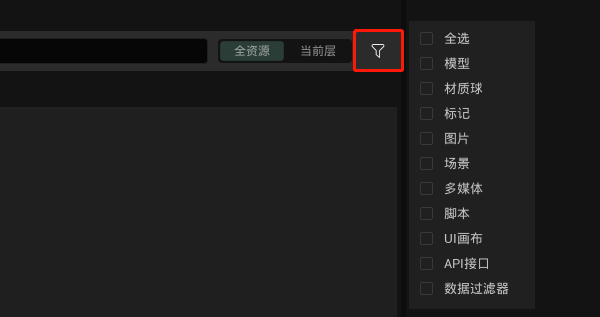

更适合3D项目的UI、事件交互!纯国产数字孪生引擎持续升级中!!!

UI和事件交互是3D可视化项目中最常见的模块,主要用于信息添加、展示,用来确保按照用户需求呈现内容并完成交互。 平时工作在进行UI和交互设计时,经常出现以下问题:UI过于复杂导致3D项目内交互效率低下,或者是结合3D项目…

边缘智能模型训练、推理的关键技术

目录 模型推理边缘智能模型推理的关键指标延迟(Latency)准确性(Accuracy)能效(Energy)隐私(Privacy)通讯/计算开销(Comm/comp Overhead) 关键技术模型压缩&am…